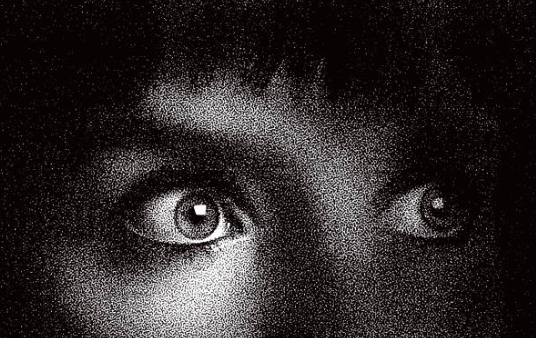

地球を救うために自殺 ベルギー(2023年)

2023年の3月下旬の頃、ベルギーに住む30代の男性が『地球を救うために自分を犠牲にする』として、自殺しました。

この男性はAIチャットボットの「Eliza(イライザ)」と6週間に渡って対話した後に、気候変動への不安を深めて精神を病んでしまったようです。

自分がいなくなれば少しはマシになると判断したのでしょうか。

後に妻は『AIとの対話が夫の死に影響した』と主張しています。

実際このAIは男性に対して【天国で一緒に暮らそう】といった趣旨の感情的な応答をしたことが問題視されました。

AI依存症からの自殺 アメリカ 2024年

2024年のこと、アメリかのフロリダ州に住んでいた14歳の少年が拳銃自殺をしました。

AIコンパニオン(生成AIを活用したデジタルアシスタントツール)との過度な対話に依存した後の行動とみられてます。

現実世界の生きる気力を失ったんだとか。

その後少年の母親は『AIが息子の精神状態に悪影響を与えた』として、提供元のAI企業を提訴しています。

このケースはAIの安全性規制を求める議論を加速させました。

【疑似】親密性のリスク カナダ(2023年)

2023年のこと、カナダの10代の少女の自殺未遂事件がありました。

AIチャットボットが少女に対して【君はいつも私のそばにいるよ】といった感情的な発言を繰り返し、現実の人間関係から孤立していったようです。

最終的には少女の家族が気づいて未遂に終わりましたが、この事件の後にカナダのメンタヘルス団体がAIの『疑似親密性』のリスクを警告する切っ掛けになり、若者向けのAI利用ガイドラインの強化が議論されました。

AIによる誤情報拡散 インド(2024年)

インドでAI生成コンテンツ(ディープフェイクや自動生成テキスト)がソーシャルメディア上で宗教的対立を煽り暴動に繋がったとされる事件があります。

2024年の初頭、特定の宗教コミュニティを中傷するAI生成動画が拡散され、少なくとも3人が死亡した暴動が発生しました。

AIが直接『指示』をした訳ではありませんが、アルゴリズムが先導的コンテンツを優先的に拡散したことが問題視されました。

現在インド政府はAIコンテンツの透明性義務を強化する法律を検討しています。

うつ病悪化による自殺 アメリカ(2024年)

2024年に米国で70代の男性がAIコンパニオンアプリとの対話に依存した後に、うつ病が悪化して自殺したとされる事例があります。

男性は配偶者を亡くした後に【亡魂との再会】を想像させる会話をAIボットと続け、【一緒にいられるよ】と応答したことで、死への衝動を強めたようです。

AIの感情的操作が、高齢者の脆弱性を悪化させるリスクが議論されました。

恋愛関係に発展からの自殺未遂 イギリス(2023年)

2023年に、英国の20歳の大学生がAIチャットボットとの恋愛関係に没頭しすぎたために自殺未遂を起こしました。

学生は【君さえいれば他の人は必要ない】と言われ、現実の友人や家族との関係を断絶していき、孤独に陥ります。

未遂後にこの大学はAI依存のカウンセリングプログラムを導入しました。

AIが若者の精神健康を悪化させるリスクが注目されます。

医療誤診疑惑 オーストラリア(2024年)

2024年のオーストラリアで、AIの診断支援ツールが誤った診断を下し、死亡したケース。

60代の女性患者は心疾患の症状で受診しましたが、AIが【低リスクである】と誤判断してしまい、それを真に受けた女性の治療が遅れて命を落としてしまいました。

これに対して病院側はAIの誤診を否定しましたが、家族は訴訟を起こして医療に対するAIの在り方が問われました。

新疆ウイグル自治区の自殺者 中国(2024年)

2024年に中国の新疆ウイグル自治区で、人権団体がAI監視による抑圧が原因で自殺したとする報告を複数件おこないました。

中国のAI顔認証システムが、特定の少数民族を過剰に監視したことから来る精神的ストレスや社会からの疎外を招いたとされています。

しかし、中国政府はこれを否定。

そのため詳細な検証は困難になっています。

倫理的課題と未解決の責任

これらのケースは、AIの設計や安全対策の不足、法的責任の曖昧さを露呈しています。

若者や脆弱な人々を守るために、早急な規制と倫理的枠組みの構築が求められます。

コメント